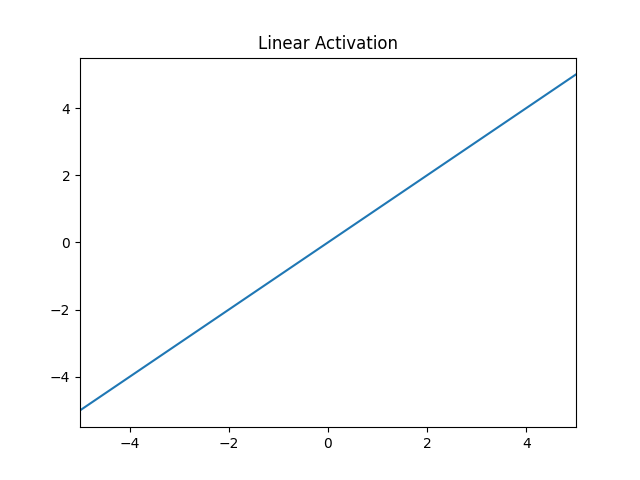

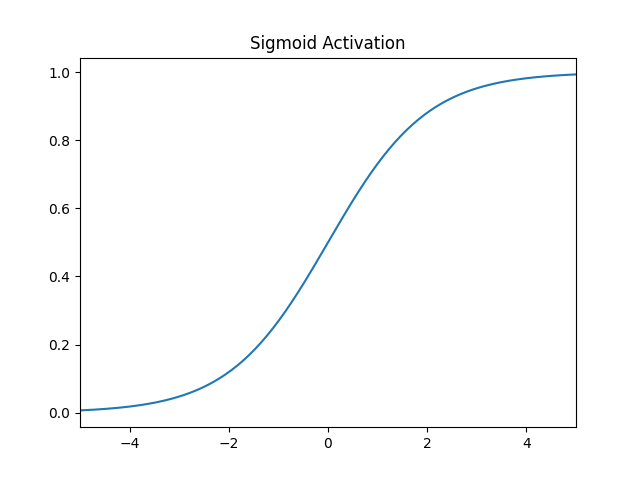

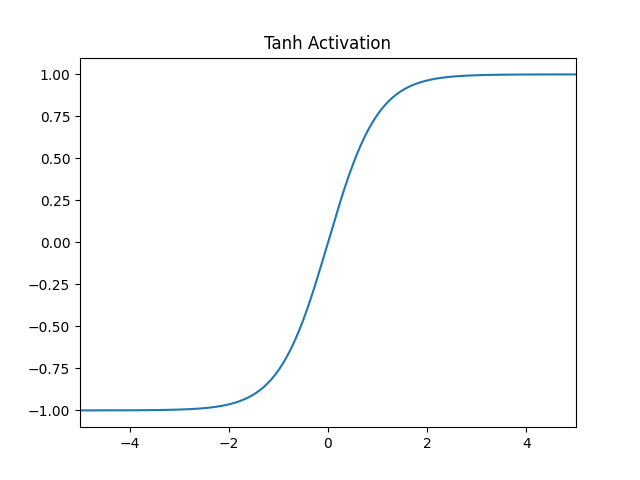

Aktivierungsfunktionen nehmen den gewichteten Input eines Neurons als Eingabe und transformieren diesen zur Ausgabe des Neurons an nachfolgende Zellen. Je nach Funktion wird die Ausgabe auf einen bestimmten Wertebereich eingegrenzt, beispielsweise auf (0;1) bei der sigmoiden Funktion. Daher werden bestimmte Aktivierungsfunktionen für spezielle Methoden bzw. Architekturen verwendet, um Vorteile ihres Wertebreichs nutzen zu können.

Nachfolgend sind die wichtigsten Aktivierungsfunktionen visualisiert und mögliche Anwendungen erläutert.

Weiterführende Links:

12 Types of Neural Network Activation Functions: https://www.v7labs.com/blog/neural-networks-activation-functions

How to choose an Activation Function for Deep Learning: https://machinelearningmastery.com/choose-an-activation-function-for-deep-learning/