Transfer Learning ist eine Methodik aus dem Bereich der Neuronalen Netze bzw. des Deep Learnings, bei dem vortrainierte Netzwerke zur Lösung von neuen Problemstellungen eingesetzt werden. Die dabei verwendeten Netzwerke sind bereits auf großen Datensätzen trainiert worden und beschleunigen das Training extrem. Transfer Learning kann in vielen verschiedenen Zwecken eingesetzt werden, lässt sich jedoch vermehrt in der Bildklassifikation oder Textverarbeitung finden. In diesem Artikel werden zunächst die Grundlagen des Transfer Learnings behandelt und anschließend an einem Beispiel verdeutlicht.

Begriffsdefinition #

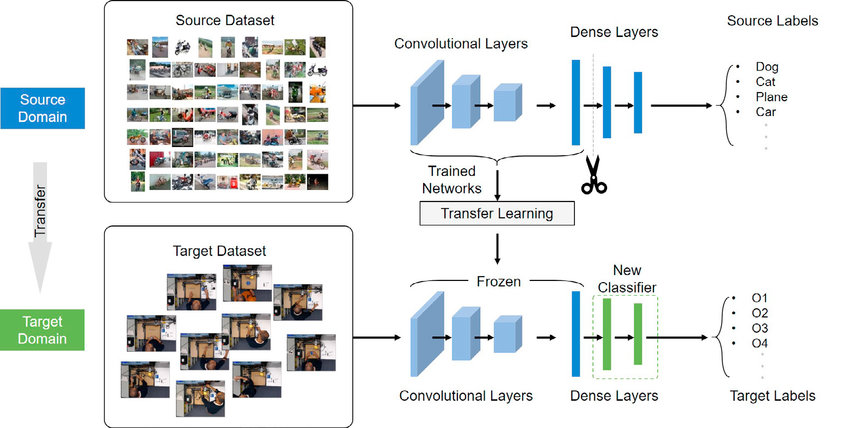

Die wesentliche Idee hinter Transfer Learning, das als eine Methodik des Deep Learnings zählt und an sich kein eigenes Lernverfahren ist, ist das transferieren von bereits gelernten Zusammenhängen auf eine neue unbekannt Problemstellung. Der wesentliche Vorteil dieser Methodik liegt darin, dass das Training nicht “von vorne” begonnen werden muss und damit zeitliche Ressourcen und Rechenleistung eingespart werden können. Zudem erfolgt das Training der Transfer Netzwerke auf großen Datensätzen, sodass bei der Anwendung auf eine neue Problemstellung häufig bessere Ergebnisse erzielt werden können als bei Verwendung von individuellen Netzwerkarchitekturen. Die nachfolgende Abbildung zeigt vereinfacht dargestellt die Funktionsweise bzw. das Vorgehen beim Transfer Learning.

Wie ersichtlich, wird zunächst ein Netzwerk auf Basis von einem großen Datensatz mit verfügbaren Labels trainiert. Gerade die Erstellung solcher Datensätze und insbesondere das Labeling von Bilder sind extrem zeitaufwändig und entfallen für EntwicklerInnen bei Nutzung von Transfer Learning. Das Netzwerk wird mit den bestehenden Klassen bestmöglich trainiert. Ein Teil des Netzes wird dann in das neue Netzwerk integriert und sozusagen “eingefroren”. Dadurch werden die Gewichte innerhalb der Schichten beim Training nicht weiter engepasst und die bereits gelernten Zusammenhänge werden in das neue Netzwerk übernommen. Daran können weitere Schichten angeschlossen werden, die entsprechend der neuen Problemstellung etwa die Klassifikation mit anderen Klassen übernehmen. Im abschließenden Abschnitt wird die Nutzung von Transfer Learning

Anwendungsfelder #

Transfer Learning wird im Wesentlichen bei der Arbeit mit unstrukturierten Daten verwendet, da diese im Normalfall große Datensätze und entsprechend lange Trainingszeiten erfordern. Dazu zählen unter anderem die folgenden beiden Anwendungsfelder

Bilder #

- Bildklassifikation: Bei der Erkennung von Inhalten in Bildern spielt Transfer Learning eine wichtigte Rolle. Netzwerke wie etwa ResNet50 oder MobileNet werden vermehrt zur Klassifikation von Bildmaterial genutzt

- Objekterkennung: Ähnlich zur Klassifikation von Bildern, bei der das Bild als Ganzes betrachtet wird und genau ein Label zugewiesen hat, kann Transfer Learning auch zur Objekterkenung genutzt werden. Dabei sind in einem Bild mehrere Objekte zu finden, denen eine Klasse zugewiesen ist.

Text #

- Übersetzungen: Anwendungen wie DeepL oder andere Übersetzer erfordern extrem große Datenmengen und viel Zeit, um die neuronalen Netze zu trainieren und dabei gute Ergebnisse zu trainieren. Bei weiteren Anwendungen in der Textverarbeitung können vortrainierte Netze verwendet werden.

- Textgenerierung: Im Gegensatz zur Übersetzung ist kein Text durch NutzerInnen vorgegeben, stattdessen müssen Modelle auf Basis von Stichworten Texte generieren. Auch dabei wird häufig Transfer Learning genutzt.

Beispiel: Bildklassifikation mit ResNet50 #

Abschließend soll das Thema Transfer Learning an einem Beispiel vertieft werden. Der nachfolgende Codeblock zeigt, wie in TensorFlow mit der Keras Model API in wenigen Zeilen Code ein Modell auf Basis des vortrainierten ResNet-50 erstellt werden kann. Bei der Verwendung ist generell darauf zu achten, welche Input Formate bzw. Shapes von einem Netzwerk untersützt werden. Im Bereich der Bildklassifikation ist es mehr oder weniger immer erforderlich, dass die Bilder drei Kanäle haben.

Das vollständige Notebook lässt sich unter dem folgenden Link finden:

https://www.kaggle.com/code/nilshmeier/transfer-learning-approach

from tensorflow import keras

from tensorflow.keras import layers, activations, applications, optimizers, losses

# Create Input Layer

input_layer = layers.Input(shape=(224,224,3))

# Add ResNet50 model and the corresconding preprocessing layer

preprocess_layer = applications.resnet50.preprocess_input(input_layer)

transfer_net = applications.ResNet50(weights='imagenet', input_tensor=preprocess_layer, include_top=False)

# Fix the weights of the ResNet Model

transfer_net.trainable = False

# Flatten the output of the transfer net and add Dropout + Classifier layers

flatten_layer = layers.Flatten()(transfer_net.output)

dropout_layer = layers.Dropout(rate=0.5)(flatten_layer)

clf_layer = layers.Dense(units=100, activation=activations.softmax)(dropout_layer)

# Create the final Keras model using input and final output layer

model = keras.Model(name='Sports-Model', inputs=input_layer, outputs=clf_layer)

# Compile the model and print summary

model.compile(optimizer=optimizers.Adam(learning_rate=0.001), loss=losses.categorical_crossentropy, metrics=['accuracy'])

# Print the model summary

print(model.summary())Weiterführende Links:

A Gentle Introduction to Transfer Learning: https://machinelearningmastery.com/transfer-learning-for-deep-learning/

Transfer Learning – Anwendungsfälle und Beispiele: https://datasolut.com/was-ist-transfer-learning/

Transfer Learning for Machine Learning: https://www.seldon.io/transfer-learning